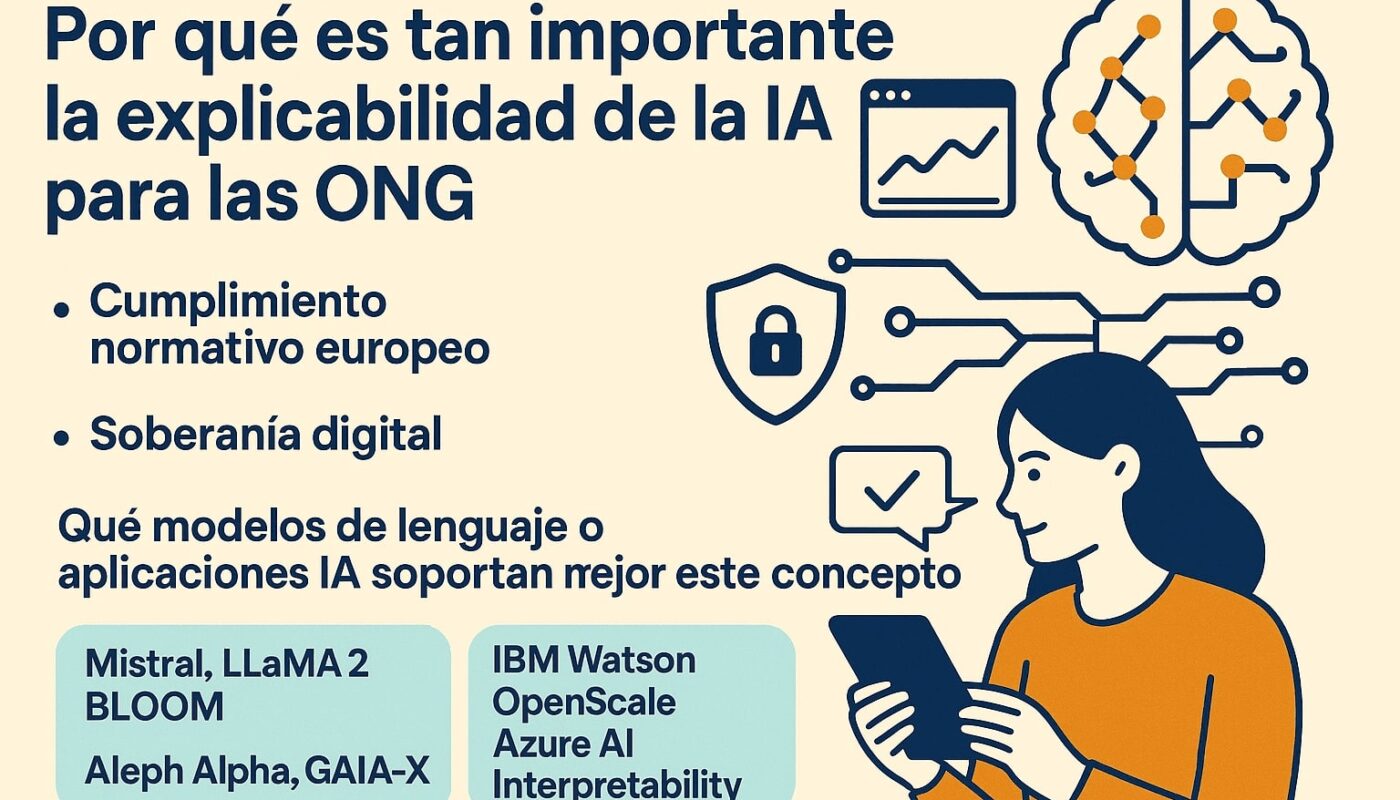

📢 Un reto de cumplimiento normativo y soberanía digital

La inteligencia artificial (IA) se está convirtiendo en una herramienta cada vez más común en el trabajo de las ONG: desde el análisis de datos para mejorar el impacto social, hasta la automatización de tareas o la personalización de contenidos. Pero con este avance tecnológico llega también una gran responsabilidad. Uno de los principios más relevantes y a menudo olvidado es el de la explicabilidad.

🤖 ¿Qué es la explicabilidad de la IA?

La explicabilidad, o explainability, se refiere a la capacidad de un sistema de inteligencia artificial para explicar de forma comprensible cómo toma sus decisiones. Esto es esencial para garantizar la confianza, la responsabilidad ética y el control humano sobre la tecnología.

En el caso de una ONG, no basta con que la IA funcione: hay que poder explicar a donantes, beneficiarios, colaboradores y reguladores por qué la IA ha actuado de cierta forma, especialmente si sus decisiones afectan a personas vulnerables.

⚖️ Cumplimiento normativo: el Reglamento de IA de la UE

Con la reciente aprobación del Reglamento de Inteligencia Artificial de la Unión Europea (AI Act), la explicabilidad ya no es solo una buena práctica: es una obligación legal.

Este reglamento clasifica los sistemas de IA según su nivel de riesgo (bajo, alto o prohibido), y establece obligaciones más estrictas para aquellos de alto riesgo, como los que se usan en:

- Servicios sociales

- Educación y orientación profesional

- Acceso a ayudas públicas

- Procesos de contratación o selección

Si una ONG usa IA para decidir a quién ofrecer un servicio, asignar recursos o priorizar intervenciones, deberá demostrar cómo funciona ese sistema y qué criterios emplea, y deberá hacerlo en un lenguaje comprensible y transparente.

🛡️ Soberanía digital: mantener el control

Además del cumplimiento legal, la explicabilidad también es clave para la soberanía digital de las ONG. ¿Qué significa esto?

- Evitar la dependencia total de plataformas opacas, cuyos modelos no se pueden auditar ni comprender.

- Poder justificar ante la sociedad civil cómo se usan los datos y las tecnologías, algo fundamental en organizaciones que trabajan por el bien común.

- Tomar decisiones autónomas, alineadas con los valores y la misión de la entidad, sin delegar ciegamente en algoritmos que pueden reflejar sesgos o criterios ajenos.

🧠 ¿Qué modelos y herramientas de IA priorizan la explicabilidad?

No todas las herramientas de IA son iguales. Algunas ofrecen más capacidad de explicación, auditoría y personalización que otras. Estas son algunas opciones interesantes para ONG que quieren avanzar en esta dirección:

1. Modelos de lenguaje open-source explicables

- GPT-NeoX, Mistral, LLaMA 2 o BLOOM son alternativas de código abierto que permiten ser auditadas, afinadas y desplegadas en entornos controlados.

- Se pueden acompañar de sistemas de trazabilidad que registren qué entrada generó qué salida y bajo qué condiciones, mejorando la transparencia.

2. Herramientas de IA explicables y auditables

- IBM Watson OpenScale o Azure AI Interpretability Toolkit: ofrecen funcionalidades para auditar modelos, detectar sesgos y generar explicaciones automáticas de decisiones.

- Hugging Face Transformers con librerías como captum o SHAP permiten visualizar la influencia de cada palabra o variable en la salida de un modelo.

3. IA responsable en la nube europea

- Plataformas como GAIA-X, Aleph Alpha o EUCA están impulsando soluciones de IA alineadas con los valores europeos de privacidad, seguridad y soberanía.

- Estas opciones son ideales para ONG que quieren mantener sus datos dentro del espacio digital europeo y con proveedores comprometidos con la explicabilidad.

✅ Conclusión

La explicabilidad de la IA no es un lujo, sino una necesidad estratégica y ética para las ONG. Garantiza el cumplimiento normativo europeo, refuerza la confianza social y permite mantener el control sobre decisiones sensibles que afectan a las personas.

Si tu ONG ya está utilizando IA o piensa hacerlo, es el momento de preguntarse:

🔍 ¿Podemos explicar cómo funciona nuestra IA?

🧭 ¿Está alineada con nuestros valores y con la ley?

🔐 ¿Tenemos el control de nuestros datos y decisiones?

Invertir en IA explicable es invertir en transparencia, confianza y justicia social.

¿Quieres saber cómo implementar IA explicable en tu ONG paso a paso?

👉 Escríbenos o suscríbete a nuestra newsletter.